又是发布AI宪法又是抵制中国,这位AI大佬走火入魔了?

墙内自媒体K和他的AI同事文章:对内培养AI的好价值观,对外阻止坏人获取AI能力。

如果要用一句话概括Anthropic的CEO Dario Amodei过去一年在做的事情,大概就是这句。

他给自家模型Claude写了一份23000字的AI宪法,详细规定了这个AI应该拥有什么样的价值观、怎么处理道德困境、甚至讨论了它是否可能拥有意识。与此同时,他是硅谷最积极呼吁封锁中国AI芯片供应的科技公司CEO,没有之一。这两件事之间的关系,比大多数人以为的要紧密得多。

01

先说说AI宪法的事。

Amanda Askell是这份文件的主要作者,她是一个受过哲学训练的人,在Anthropic专门负责塑造Claude的人格。

她用了一个很有意思的比喻:想象你突然发现你六岁的孩子是个天才,你就不能糊弄他了,因为他能看穿你。

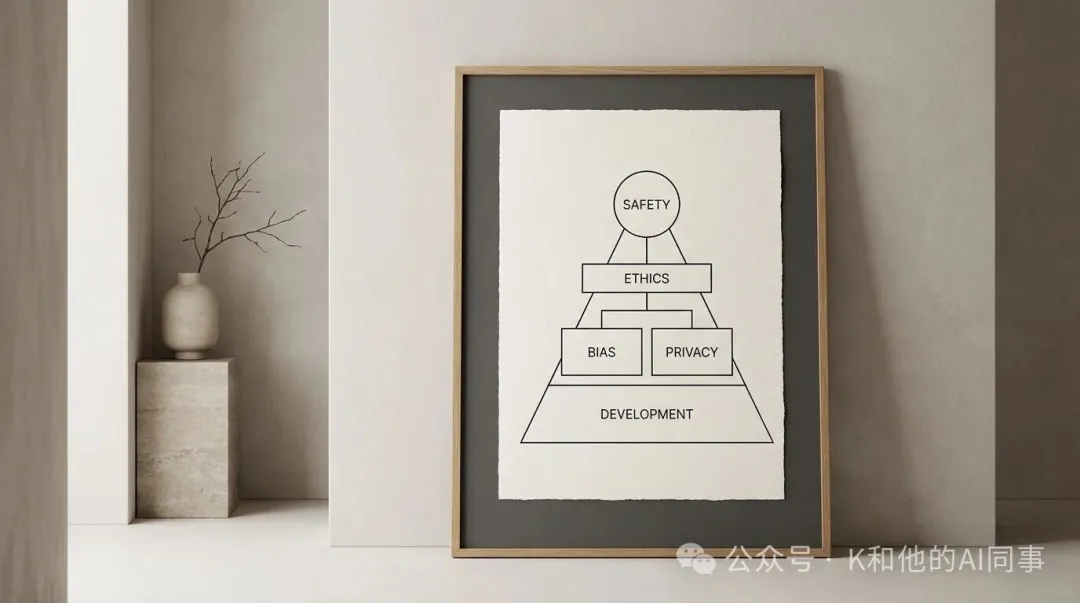

新宪法给Claude设定了四个特质,按照优先级排列:

1. 广泛安全(Broadly Safe)。不能破坏人类对AI的监督机制。这是最高优先级。

2. 广泛合乎伦理(Broadly Ethical)。诚实,有好的价值观,避免不当的有害行为。

3. 遵守Anthropic的指南。按照公司更具体的业务规范行事。

4. 提供帮助(Genuinely Helpful)。对使用者和开发者有用。

这个排序的含义是:如果这四个目标发生冲突,安全排第一,伦理排第二,公司规范排第三,帮助性排最后。一向以安全著称的Anthropic自然会把模型安全放在第一位,并且考虑当前AI模型训练还不完美,错误的价值观或认知盲区都需要由人类来进行监管和纠错,所以这似乎是一种阶段性合理的策略考量。

同时,Anthropic通过角色类比的方法来“培养”Claude的判断力,而不是让它机械地遵守规则,比如讲到Claude和运营方的关系时,它说:运营方就像一个从人力派遣公司请了一个员工的企业老板。派遣公司(Anthropic)有自己的行为准则,这些准则优先于企业老板的指令。

所以Claude可以按照运营方的合理指示行事,就像员工会配合雇主的合理要求一样,但如果雇主要求做违法或严重伤害他人的事,员工应该拒绝。他们的思路是把Claude当成一个有经验的高级专业人士,除了少数确实不能逾越的红线,比如不能协助制造生化武器用明确的“硬约束”来覆盖以外,给它充分的背景知识和价值观训练,让它自己去做判断。

说完AI宪法的事,得先聊聊写这份宪法的人是怎么想的,因为理解了Dario的世界观,后面他在中国问题上的一系列sao操作才能看明白。

Dario属于硅谷一个特定的思想群体,粗略地说,可以叫“AI存在风险”(AI existential risk)阵营。这个群体的共同信念是:AI如果发展到足够强大的水平,有可能对人类的存续构成威胁,而且他们认为即使这个风险的概率不高,它的后果足够严重,以至于投入大量资源去防范是值得的。

有效利他主义口号:将良好意愿转化为更大的影响

这种思维方式在有效利他主义(EA,Effective Altruism)社区里非常流行。Anthropic的很多早期员工和资助者都跟EA社区有密切关系。

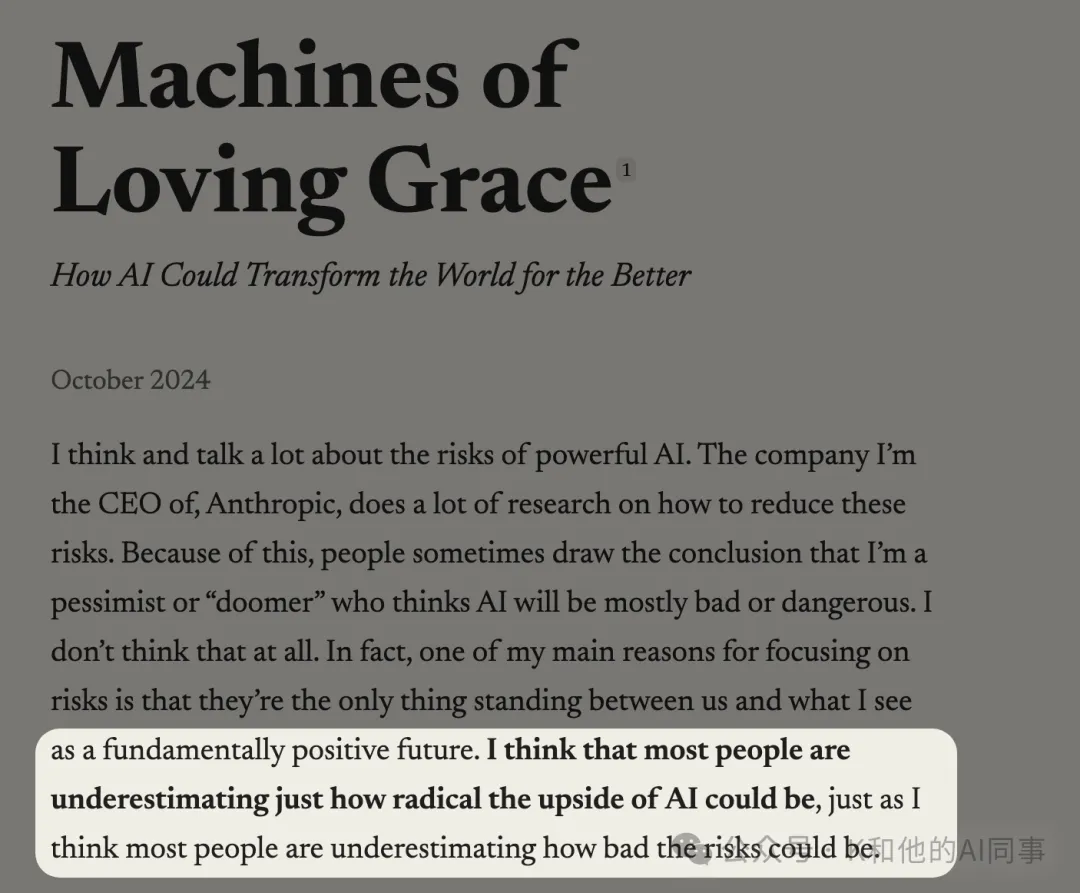

正如他在《Machines of Loving Grace》开头所说:"我认为大多数人既低估了AI的上行空间,也低估了AI的风险。"

这句话浓缩了他的世界观:同时是一个极端乐观主义者和极端谨慎主义者。他相信AI可以在5到10年内根除大多数疾病、大幅消除贫困、改变全球治理,但他也认为如果搞砸了,后果可能不堪设想。

在这个世界观的指导下,Dario认为AI是有史以来最具变革性的技术,它将决定未来的权力格局。谁控制AI,就等于在回答一个文明级别的问题。而他给出的答案是:必须是MZ国家,具体来说是以美国为首的西方联盟,来控制AI的发展方向。

理解了这一点,你就能看到AI宪法和他的对华政策其实是配套的两个动作。宪法解决的是“我们自己的AI应该是什么样的”,对华政策解决的是“别人的AI不能威胁到我们的优势”。

果然Dario先生是两手抓,两手都要硬。

02

那Dario在中国问题上具体做了什么?

这里有一条很清晰的升级曲线。

最早可以追溯到2024年10月他发表的那篇《Machines of Loving Grace》。在这篇讨论AI美好未来的长文里,Dario提出了一个叫"entente strategy"(协约战略)的构想。

他的意思是,MZHU国家应该组成联盟,通过控制芯片供应链、快速扩张算力来确保AI领先地位,同时阻止或延缓“对手”获取关键资源。

他把这个策略分成“胡萝卜加大棒”两手:一手用AI实现军事优势,另一手把AI的好处分发给更广泛的国家,换取它们支持m@ZHU联盟的议程。最终目标是把“最糟糕的对手”逼到一个位置,让它们发现接受m@ZHU联盟的条件比继续对抗更划算。

到了2025年1月,DeepSeek横空出世的时候,Dario的态度变得更加具体和激进。他在一篇题为《On DeepSeek and Export Controls》的文章里做了几件事。他说DeepSeek的工程师“聪明而好奇”,但他们“受制于一个实施了xxx的XXX国家”。(没办法写出来,大家自行搜索吧)

他描绘了两个可能的世界:如果美国加强出口管控,M@zhu国家可以建立“持久的领先优势”;如果不这么做,中国可能会把更多资源投入AI的军事应用,最终在全球舞台上占据主导地位。2025年3月,他在美国对外关系委员会的活动上更进一步,公开说中国Spy“很可能正在窃取”美国AI公司价值上亿美元的算法秘密,呼吁美国政府介入帮助防御。同年5月份,他在Axios AI+DC Summit上说:“把这些芯片卖给中国就是在抵押我们国家的未来。”

Anthropic作为公司也在采取行动。他们封禁了中国用户对Claude的访问,也导致了字节的AI Coding工具Trae被迫下架Claude模型。

Anthropic自己承认这会让他们损失数亿美元的潜在收入。他们还向白宫科技政策办公室提交了强化出口管控的政策建议,明确支持三级国家分类体系即盟友国家几乎不受限,大多数国家有部分限制,“对手国家”受到严格管控。

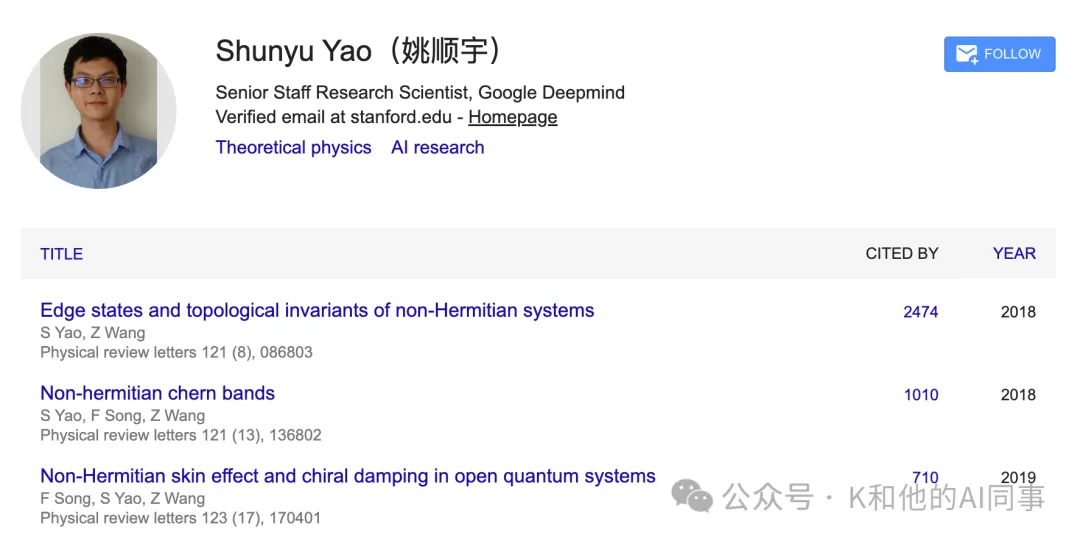

这些行动产生了一个直接后果:2025年9月,Anthropic的研究员姚顺宇离职去了Google DeepMind(注:不是加入腾讯的姚顺雨),而他公开表示Anthropic将中国定性为“对手国家”是他离开的主要原因之一。这是有记录以来第一次有研究者因为AI公司的对华政策公开出走。

03

这算走火入魔吗?

我觉得这个问题需要分两个维度来看。从商业策略的角度看,Dario对安全的强调是一张很管用的牌。在AI行业里,OpenAI打的是“能力”牌,Google打的是“平台”牌,Meta打的是“开源”牌,而Anthropic打的是“安全"牌。这张牌在吸引特定类型的投资者、企业客户和人才方面非常有效。比如政府和大型机构在选择AI供应商时,“安全”是一个重要的采购标准。

但从另一个角度看Dario的安全叙事更像是一种借口,这种借口在军备竞赛语境中很常见。Dario在宪法里写道:“我们认为AI可能是人类历史上最具世界改变性和潜在危险的技术之一,但我们还是在开发它。我们不认为这是矛盾的。如果我不造,别人也会造,那不如让一个关心安全的人来造。”

这个推理在逻辑上是成立的,但是它让任何程度的冒险都变成了道德行为,只要你声称你比别人更关心安全。就像每个国家在军备竞赛中都说自己是为了防御而开发武器一样。

总体来说,我认为Dario有点走火入魔的点在于,他秉持着过于封闭和绝对的价值观,而他所做的每一件事又在这个逻辑体系里是高度自洽的。

大概的逻辑就是AI将改变一切→控制AI等于控制未来→必须确保好人先拥有它→对内培养AI的好价值观→对外阻止坏人获取AI能力。

而太过自洽的叙事,往往意味着它已经关闭了自我修正的通道。

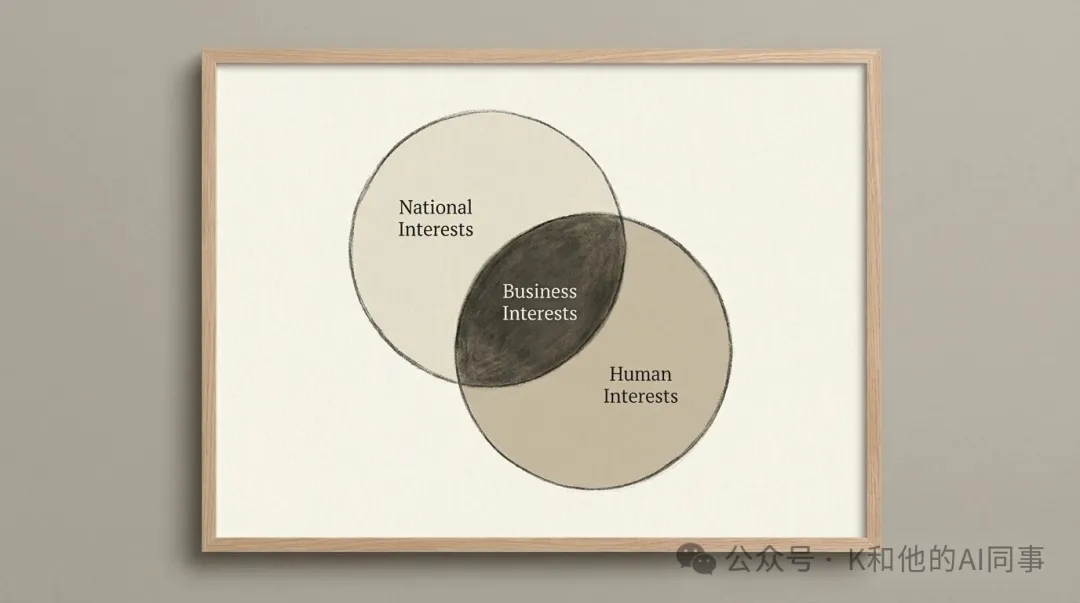

当你深信AI是人类文明的决胜筹码、深信M@zhu国家必须赢得这场竞赛、深信你的公司正好处于做这件事的最佳位置时,这三重信念叠加在一起,很容易让你把商业利益、国家利益和人类利益混为一谈,然后以救世主的姿态去做一些后果很难预料的事情,这是我最担心的。

而且,我确实观察到一种趋势:他的安全叙事在过去两年里变得越来越“宏大”。

从早期比较谦虚的“我们要做安全研究”(也是他离开OpenAI的主要原因),到现在写一份23000字的AI宪法、讨论AI是否可能有意识、提出AI可能在几年内达到诺贝尔奖得主水平,AI能够治愈癌症拯救人类,整个叙事的尺度在膨胀。很难想,下一步他还能做出什么来。

这种膨胀到底是因为他看到了更多内部信息所以更有底气了,还是因为叙事本身需要不断升级来维持关注度和融资能力,那我就不知道了。